Колишній керівник відділу продуктів facebook френсіс хауген 5 жовтня 2021 року дала свідчення в сенаті сша про те, що соціальні медіа-платформи компанії “шкодять дітям, розпалюють ворожнечу і послаблюють демократію”.

Хауген була основним джерелом інформації для викривального матеріалу wall street journal про компанію. Вона назвала алгоритми facebook небезпечними, заявила, що керівники facebook усвідомлювали ризик, але ставили доходи вище інтересів людей, і закликала конгрес керувати компанією.

При розробці контенту, який ви бачите, платформи соціальних мереж у своїй роботі спираються на звички людей. Якщо говорити прямо, то вони очікують контент, на який люди реагують або “залучаються”, ставлять лайки, коментують або діляться ним. Фабрики тролів, організації з розповсюдження матеріалів провокаційного змісту, зловживають цим, займаючись копіюванням матеріалів з найбільш активною участю і публікуючи їх в якості своїх власних, що сприяє залученню великої кількості передплатників.

Від левів у савані до лайків на facebook

Ідея “знання натовпу” передбачає, що використання індикаторів дій, думок і уподобань інших людей в якості інформації призведе до обґрунтованого вибору. Наприклад, колективні прогнози зазвичай більш вірні, ніж індивідуальні. Колективний розум використовується для прогнозування фінансових ринків, спортивних подій, виборів і навіть спалахів захворювань.

Протягом десятків мільйонів років еволюції ці ідеї були закодовані в людському мозку у вигляді когнітивних упереджень, які включають такі назви, як знайомство, просте вплив і ефект бандвагона. Якщо всі працюють, то і вам потрібно приступити до роботи; ймовірно, що хтось виявив “наближення левів”, і робота може зберегти ваше життя. Звичайно, ви навряд чи дізнаєтеся причину, але безсумнівно мудріше задавати питання пізніше.

Ваш мозок вловлює підказки з обстановки – разом з вашими друзями – і використовує прості правила, щоб швидко перетворити ці індикатори на вибір: піти з переможцем, слідувати більшості, копіювати свого сусіда. Ці правила чудово працюють в типових умовах, тому що вони засновані в основному на здорових припущеннях. Наприклад, вони припускають, що люди зазвичай діють раціонально, малоймовірно, що багато помиляються, минуле пророкує майбутнє і так далі.

Технології дозволяють людям отримувати показники від набагато більшого числа інших людей, про більшість з яких вони не мають ні найменшого уявлення. Цілі штучного інтелекту активно використовують ці показники розпізнавання або “залученості”, від прийняття рішень за результатами пошукових систем до рекомендації музики і фільмів, від пропозиції асоціацій до оцінки постів в інформаційних стрічках.

Не все вірусне дійсно є таким

Проведений аналіз показує, що майже всі мережеві технологічні платформи, такі як соціальні мережі та інформаційні поради, мають потужний ухил у бік популярності. Коли цілі підштовхуються такими ознаками, як зацікавленість, а не експрес-запити в пошукових системах, упередженість в плані розпізнавання може призвести до небезпечних ненавмисних наслідків.

Соціальні мережі, такі як facebook, instagram, twitter, youtube і tiktok, тісно покладаються на алгоритми штучного інтелекту для ранжирування і просування контенту. Ці алгоритми враховують те, що вам подобається, що ви торкаєтеся і чим ділитеся – іншими словами, контент, з яким ви взаємодієте. Мета алгоритмів-максимізувати залученість, з’ясовуючи, що подобається людям, і поміщаючи це на перші місця в їх стрічках.

На перший погляд, це цілком виправдано. Якщо людям подобається достовірна інформація, обґрунтовані думки і приємні фільми, то алгоритми повинні створювати такий високоякісний контент. Але знання натовпу робить ключове припущення: що рекомендація того, що в моді, допоможе високоякісному контенту “спливти”.

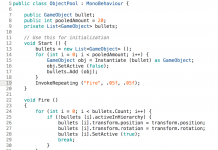

Підручник з алгоритму facebook

Це твердження було перевірено шляхом вивчення алгоритму, який оцінює рейтинг об’єктів, використовуючи поєднання показників якості та розпізнавання. З’ясувалося, що в цілому упереджене ставлення до розпізнавання з високою часткою ймовірності знижує якість контенту в цілому. Це пов’язано з тим, що впізнаваність не є надійним показником високої якості, якщо з матеріалом було ознайомлено дуже незначна кількість людей. У таких ситуаціях показники активності генерують тривожний сигнал, і алгоритм, найімовірніше, просто посилить цей шумовий ефект. Коли рівень популярності низькоякісного продукту стає досить високим, він як і раніше повинен продовжувати посилюватися.

Алгоритми – не єдиний фактор, на який впливає упередженість оцінки залученості – вона може впливати і на людей. Факти показують, що інформація передається за допомогою “складного зараження”, тобто чим частіше люди знайомляться з будь-якої концепцією в мережі, тим більша ймовірність того, що вони приймуть її і повторно поширять. Коли соціальні медіа повідомляють людям, що товар став вірусним, їх когнітивні упередження включаються і перетворюються на непереборне бажання зосередитися на ньому і поділитися ним.

Не надто розсудлива аудиторія

Не так давно був проведений експеримент з використанням програми для навчання новинної грамотності під назвою fakey. Це програма, яка імітує інформаційну стрічку, подібну до facebook і twitter. Учасники бачать суміш статей з справжньої та брехливої інформації, лженауки, ангажованих та упереджених джерел, а також з авторитетних джерел. Вони отримують бонуси за те, що діляться або ставлять лайк інформації з надійних джерел, а також за те, що відзначають статті з низькою достовірністю для перевірки фактів.

З’ясувалося, що геймери охочіше діляться інформацією і рідше відзначають статті з джерел з низьким ступенем достовірності, коли бачать, що багато клієнтів звернулися до цих статей. Таким чином, демонстрація показників взаємодії створює вразливість.

Дослідження із залученням аудиторії не працює, так як воно побудовано на помилковій передумові, що аудиторія складається з різних, неупереджених джерел. Причин, за якими це не так, може бути кілька.

По-перше, через те, що люди схильні об’єднуватися з однодумцями, їх онлайнове оточення не надто різноманітне. Легкість, з якою користувачі соціальних мереж можуть видаляти з друзів тих, з ким вони не згодні, штовхає людей в однорідні спільноти, іноді звані ехо-камерами.

По-друге, оскільки багато людей є однодумцями один одного, вони впливають один на одного. Відомий експеримент показав, що з’ясування того, яка музика подобається вашим близьким, впливає на ваші індивідуальні визнані переваги. Ваше соціальне бажання пристосуватися спотворює ваші неупереджені судження.

По-третє, показники розпізнавання можна підтасувати. Протягом багатьох років пошукові системи, такі як google, розробили тонкі методи боротьби з так званими “фермами посилань” та іншими схемами маніпулювання пошуковими алгоритмами. Платформи соціальних мереж, з іншого боку, тільки починають дізнаватися про свої власні вразливості.

Особи, які прагнуть маніпулювати інформаційним ринком, створюють підроблені акаунти, наприклад, тролів і соціальних ботів, і організовують фальшиві мережі. Вони затопили мережу, щоб створити видимість того, що теорія змови або політичний кандидат в тренді, обманюючи алгоритми платформ і безпосередньо когнітивні упередження людей. Вони навіть змінили структуру соціальних мереж, щоб створити ілюзію думки більшості.

Зниження залученості

Що робити? в даний час технологічні платформи знаходяться в стані оборони. Під час виборів вони стають більш агресивними в боротьбі з фальшивими акаунтами і шкідливою дезінформацією. Але ці зусилля можуть бути схожі на гру в піжмурки.

Можна застосувати окрему, попереджувальну тактику – додати додатковий тиск. Інакше кажучи, уповільнити поширення інформації. Наприклад, такі види поведінки, як автоматичне проставлення лайків або обмін думками, можуть стримуватися шляхом використання captcha, для відповіді на які потрібна участь людини, або стягування додаткової плати. Це не тільки зменшить можливості для маніпуляцій, але й дозволить людям приділяти більше уваги тому, що вони бачать. Це дасть набагато менше можливостей для упередженого ставлення, яке може вплинути на вибір людей.

Крім того, було б корисно, якби корпорації соціальних мережСкорегували свої алгоритми, щоб при виборі контенту вони в меншій мірі покладалися на показники залученості і більшою мірою на показники якості. Можливо, викриття викривачів дадуть необхідний імпульс.