Introductie

De integratie van AI in het onderwijs versnelt, waarbij grote technologiebedrijven zwaar investeren in door AI aangedreven leermiddelen. OpenAI, Google en Anthropic hebben onlangs nieuwe leer- en studieversies van hun modellen onthuld, ontworpen om als AI-docenten te functioneren. Mashable testte deze tools om hun effectiviteit te beoordelen, rekening houdend met de bredere context van de rol van AI in het onderwijs en mogelijke valkuilen. Het doel van dit overzicht is om inzicht te geven in de vraag of deze hulpmiddelen daadwerkelijk het leerproces ondersteunen of niet aan de verwachtingen voldoen.

De opkomst van AI-docenten en contextuele uitdagingen

De introductie van AI-docenten weerspiegelt een groeiende trend in de richting van het integreren van technologie in het onderwijs, een weerspiegeling van de adoptie van laptops en bibliotheken. Het ‘vijf procentprobleem’ benadrukt echter een terugkerende uitdaging bij het ontwerpen van onderwijstechnologie: hoewel zeer gemotiveerde studenten hiervan kunnen profiteren, ondervindt de meerderheid (ongeveer 95%) mogelijk geen substantiële verbeteringen. Dit is gedeeltelijk te wijten aan de focus op kortetermijnwinst, zoals cijfers, in plaats van op dieper inzicht. Bovendien ontberen veel AI-tools personalisatie en context, wat hun vermogen om tegemoet te komen aan individuele leerstijlen en curricula belemmert.

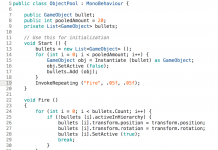

Methodologie: AI-docenten testen

Om deze hulpmiddelen te evalueren, analyseerde Mashable vragen rechtstreeks uit het New York Regents Exam, de New York State Common Core Standards, AP-examens en sociaal-wetenschappelijke curricula van het Learning for Justice-programma van het Southern Poverty Law Center. In plaats van zich te concentreren op typische STEM-aanwijzingen, omvatte de review geesteswetenschappelijke vragen om de mogelijkheden van de tools te beoordelen op gebieden waar AI kritiek kreeg. Het doel was om de typische aanpak van een leerling te simuleren: beginnen met een verzoek om huiswerkhulp en het gesprek op een natuurlijke manier laten verlopen totdat het niet meer hielp.

Belangrijke inzichten van experts

Hamsa Bastani, universitair hoofddocent aan de Wharton School van de Universiteit van Pennsylvania, benadrukt dat het begrijpen van het gedrag van gemiddelde studenten cruciaal is. Ze merkt op dat bestaande generatieve AI-chatbots vaak een nieuwe bestemming krijgen in plaats van specifiek ontworpen te zijn om te leren, wat leidt tot onvoldoende waarborgen tegen onthullende antwoorden. Dylan Arena, hoofd datawetenschap en AI-functionaris bij McGraw Hill, gebruikt de analogie van het achteraf inbouwen van een moderne motor in een oudere machine, en benadrukt daarmee de uitdaging van het integreren van AI in bestaande onderwijskaders en de behoefte aan diepere personalisatie die verder gaat dan alleen het vragen om gebruikersinformatie.

Beoordeling van AI-docenten

- ChatGPT: Hoewel het bedreven is in oefentoetsen en het verduidelijken van beoordelingsnormen, geeft het vaak direct antwoorden en geeft prioriteit aan oefenen uit het hoofd, wat het frustrerend maakt voor complexe vragen.

- Gemini: Blinkt uit in wiskunde-instructie en biedt opties zoals flashcards en quizzen, maar is gevoelig voor het genereren van nutteloze beoordelingen en legt de nadruk op oefenen boven begrip.

- Claude: Richt zich op het leerproces in plaats van op perfecte cijfers, waardoor het geschikt is voor studenten in de sociale wetenschappen die bereid zijn kritische denkvaardigheden op te bouwen, maar overdreven socratisch en veeleisend kunnen zijn.

Laten we realistisch worden: beperkingen en zorgen

Ondanks hun verschillende benaderingen delen alle drie de AI-docenten gemeenschappelijke beperkingen:

- Ontwerp: Het chatbotformaat, met zijn beperkte tekstvenster en gebrek aan visuele elementen, is niet ideaal om te leren, vooral als het gaat om het begrijpen van complexe concepten.

- Personalisatie: AI-docenten missen context over individuele studenten en hun curricula, waardoor het vermogen om lessen echt te personaliseren wordt belemmerd.

- Sociaal bewustzijn: AI-docenten missen vaak de flexibiliteit en het sociale bewustzijn van een menselijke leraar, wat leidt tot een eindeloze cyclus van optimalisatie en moeilijkheden om tot een definitief antwoord te komen.

McGraw Hill’s aanpak: een veiliger alternatief

McGraw Hill biedt een andere aanpak, waarbij AI-tools rechtstreeks in het educatieve materiaal worden geïntegreerd. Dit elimineert de behoefte aan door de student verstrekte context en biedt een meer gecontroleerde omgeving. Bovendien biedt de beoordelingstool ALEKS van het bedrijf een veiligere manier om persoonlijke leerprofielen van studenten op te bouwen en terug te koppelen naar AI-functies.

Conclusie: Chatbots kunnen geweldige leraren niet vervangen

Hoewel AI-docenten enkele voordelen kunnen bieden, kunnen ze de expertise en het aanpassingsvermogen van een menselijke leraar niet vervangen. Uiteindelijk heeft de huidige generatie chatbots moeite om een echt gepersonaliseerde en boeiende leerervaring te bieden. Er is meer werk nodig om AI-tools te creëren die deze beperkingen aanpakken en aansluiten bij de sociale en contextuele aspecten van effectief leren.